Da Microsoft un nuovo modello AI talmente efficiente che può essere eseguito via CPU

I ricercatori di Microsoft hanno sviluppato un modello di intelligenza artificiale estremamente efficiente che funziona anche su CPU standard. BitNet b1.58 2B4T vuole rappresentare un importante passo avanti nella democratizzazione dell'accesso alle capacità avanzate di AI.

di Nino Grasso pubblicata il 17 Aprile 2025, alle 14:21 nel canale WebMicrosoft

Microsoft Research ha recentemente rilasciato BitNet b1.58 2B4T, il primo modello linguistico di grandi dimensioni (LLM) nativo a 1 bit con 2 miliardi di parametri. Addestrato su un corpus di 4 trilioni di token (equivalenti a circa 33 milioni di libri), segna un progresso significativo nel campo dell'IA efficiente. La caratteristica principale è la sua architettura basata su pesi quantizzati a soli tre valori (-1, 0 e 1), approccio che riduce i requisiti di memoria e potenza di calcolo rispetto ai modelli tradizionali.

Le prestazioni dichiarate di questo modello sono interessanti considerando la sua efficienza. Secondo i test condotti dai ricercatori, BitNet b1.58 2B4T supera modelli rivali di dimensioni simili come Llama 3.2 1B di Meta, Gemma 3 1B di Google e Qwen 2.5 1.5B di Alibaba su diversi benchmark, inclusi GSM8K (una raccolta di problemi matematici a livello di scuola elementare) e PIQA (che valuta le capacità di ragionamento fisico di buon senso).

Efficienza computazionale senza precedenti per il nuovo modello AI di Microsoft

BitNet b1.58 2B4T richiede, poi, solo 0,4 GB di memoria (escludendo gli embedding) rispetto ai 2 GB di Llama 3.2 1B o ai 4,8 GB di MiniCPM 2B. La latenza di decodifica su CPU è di appena 29 ms, quasi la metà rispetto ai 48 ms di Llama 3.2 1B, come riportato nel repository ufficiale di Hugging Face, e il consumo energetico stimato è di soli 0,028 J, un valore nettamente inferiore rispetto ai modelli concorrenti.

Per garantire l'accessibilità e consentire l'implementazione su dispositivi privi di GPU potenti (come dispositivi edge, laptop o server standard), i ricercatori hanno sviluppato bitnet.cpp, una libreria C++ che funge da implementazione di riferimento ufficiale per l'inferenza via CPU dei modelli LLM a 1 bit, e che fornisce kernel ottimizzati per l'esecuzione efficiente su architetture CPU standard, evitando il sovraccarico delle librerie di quantizzazione generiche. Il modello è disponibile in diverse varianti su Hugging Face: la versione principale con pesi a 1,58 bit ottimizzati per l'inferenza efficiente, una versione con pesi master in formato BF16 per scopi di addestramento o fine-tuning, e una versione in formato GGUF compatibile con la libreria bitnet.cpp per l'inferenza su CPU.

Un limite attuale dell'implementazione è che per ottenere i vantaggi di efficienza promessi è necessario utilizzare il framework personalizzato di Microsoft, bitnet.cpp, che al momento funziona solo con determinati hardware. Assenti dall'elenco dei chip supportati sono le GPU, che dominano il panorama delle infrastrutture AI, e questo rappresenta una sfida per l'adozione diffusa della tecnologia senza però diminuire il potenziale impatto che modelli come BitNet potrebbero avere in futuro.

La possibilità di eseguire modelli linguistici avanzati su CPU standard, fra cui ad esempio il chip Apple M2, potrebbe però ampliare notevolmente l'accessibilità di queste tecnologie, portandole potenzialmente a nuovi casi d'uso e applicazioni dove finora erano considerate impraticabili per motivi di costo o requisiti hardware.

REDMAGIC 10 Air: potenza da gaming in un corpo leggero e moderno. Recensione

REDMAGIC 10 Air: potenza da gaming in un corpo leggero e moderno. Recensione Insta360 X5: è sempre la regina delle action cam a 360 gradi. Recensione

Insta360 X5: è sempre la regina delle action cam a 360 gradi. Recensione Renault Emblème: la familiare del futuro elettrica, sostenibile e riciclabile

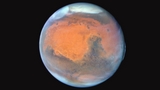

Renault Emblème: la familiare del futuro elettrica, sostenibile e riciclabile  Rilasciate nuove immagini di Marte catturate dal telescopio spaziale Hubble per celebrare il 35° anniversario

Rilasciate nuove immagini di Marte catturate dal telescopio spaziale Hubble per celebrare il 35° anniversario Project G-Assist Plug-In Builder: con l'IA di NVIDIA le funzionalità te le crei da solo

Project G-Assist Plug-In Builder: con l'IA di NVIDIA le funzionalità te le crei da solo Galaxy Watch Ultra gratis o scontato? Per Samsung basta camminare 200.000 passi

Galaxy Watch Ultra gratis o scontato? Per Samsung basta camminare 200.000 passi Ghost of Yotei, un nuovo trailer e una Collector's Edition. Arriverà su PS5 il 2 ottobre

Ghost of Yotei, un nuovo trailer e una Collector's Edition. Arriverà su PS5 il 2 ottobre FRITZ!Box 6860: banda larga ovunque grazie al 5G

FRITZ!Box 6860: banda larga ovunque grazie al 5G Tesla in crisi: crollano i profitti e Musk 'abbandona' il governo Trump

Tesla in crisi: crollano i profitti e Musk 'abbandona' il governo Trump NVIDIA DLSS: oltre 760 giochi utilizzano la tecnologia, quasi il doppio rispetto ad AMD FSR

NVIDIA DLSS: oltre 760 giochi utilizzano la tecnologia, quasi il doppio rispetto ad AMD FSR FRITZ!Box 4690: nuovo router con connettività Wi-Fi 7 e LAN 10 Gbit/s per casa e lavoro

FRITZ!Box 4690: nuovo router con connettività Wi-Fi 7 e LAN 10 Gbit/s per casa e lavoro Secondo docking e primo trasferimento di energia per i due satelliti della missione ISRO SpaDeX

Secondo docking e primo trasferimento di energia per i due satelliti della missione ISRO SpaDeX L'Aquila, auto elettriche, moto elettriche e e-bike costano meno: fino a 8.000 euro di incentivi locali

L'Aquila, auto elettriche, moto elettriche e e-bike costano meno: fino a 8.000 euro di incentivi locali Anthropic: tra un anno i dipendenti virtuali AI saranno realtà nelle aziende

Anthropic: tra un anno i dipendenti virtuali AI saranno realtà nelle aziende Social media e adolescenti: la battaglia invisibile per la salute mentale

Social media e adolescenti: la battaglia invisibile per la salute mentale Osservazione della terra: il modello di IA TerraMind di IBM ed ESA è ora open source

Osservazione della terra: il modello di IA TerraMind di IBM ed ESA è ora open source NVIDIA GeForce RTX 5060 Ti 8GB: inaccettabile secondo una recensione indipendente

NVIDIA GeForce RTX 5060 Ti 8GB: inaccettabile secondo una recensione indipendente

2 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoDevi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".