Intel mostra come abbinare GPU integrata e dedicata migliori le prestazioni

Intel rispolvera il concetto di Explicit Multi-Adapter supportato dalle DirectX 12 da diversi anni per mostrare come unire la potenza di calcolo di GPU integrata e dedicata sia benefico sotto molti aspetti per le prestazioni.

di Manolo De Agostini pubblicata il 20 Marzo 2020, alle 16:01 nel canale Schede VideoIntel

La Game Developers Conference (GDC) 2020 si sarebbe dovuta tenere tra il 16 e il 20 marzo a San Francisco, ma è slittata a causa della pandemia di Coronavirus e al momento gli organizzatori prevedono di tenere un evento dal 4 al 6 agosto. Alcuni degli annunci e delle presentazioni che si dovevano tenere alla GDC stanno arrivando sotto altre forme e tra questi l'interessante presentazione "Multi-Adapter with Integrated and Discrete GPUs" pubblicata da Intel.

Il colosso dei microchip, atteso al ritorno nel mondo delle GPU dedicate quest'anno con le soluzioni Xe, ha parlato di come le Direct3D 12 permettano di usare contemporaneamente le risorse di calcolo della GPU integrata nel microprocessore e di una scheda video dedicata. "I PC gaming solitamente accoppiano una CPU ad alte prestazioni con una scheda video dedicata. Le CPU spesso includono della grafica integrata che di solito rimane inattiva (idle). Esploriamo i casi - asynchronous compute e post-processing - dove le ultime GPU integrate Intel aggiungono significative prestazioni quando accoppiate a una GPU dedicata".

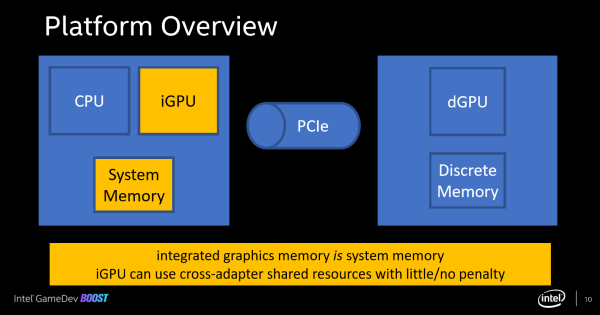

Intel, in un video e nelle immagini che vedete, parla di come sgravare la GPU della scheda video dedicata da alcuni calcoli usando la GPU integrata, usando una funzionalità presente nelle librerie DirectX. È un concetto non nuovo a dire la verità, se ne parla sin dal debutto delle DX12, ma non è mai stato perseguito realmente dagli sviluppatori. Il fatto che Intel ne parli nel 2020 lascia la speranza che tale possibilità venga rilanciata e adottata su ampia scala in futuro.

Nel caso specifico si vede l'uso contemporaneo della GPU integrata UHD Graphics 630 e di una GPU dedicata Radeon RX 560, dove la prima è dedicata al calcolo della simulazione (compute shader) delle particelle, lasciando così alla GPU Radeon più potenza per il rendering grafico. Il tutto avviene grazie allo spostamento di dati nella memoria locale della GPU dedicata, in modo che tutti i tre passaggi – simulazione, copia e rendering – avvengano in parallelo.

Intel afferma che ci sono due modi di far lavorare insieme due GPU in Direct3D 12. Il primo si chiama Linked Display Adapter (LDA), e si configura come una GPU con più nodi e le risorse copiate tra i nodi. Intel ha dichiarato che si tratta di un funzionamento simmetrico, il che significa che bisogna usare GPU identiche.

Il secondo si chiama Explicit Multi-Adapter, ed è quello perseguito da Intel, dove le risorse vengono condivise ed è possibile abbinare GPU differenti, anche di un produttore diverso, non solo in termini di potenza. Intel ha parlato di tre modi di usare questa tecnologia. La prima è condividere il rendering, facendo riprodurre un frame a una GPU e un frame all'altra, ma secondo l'azienda non è una soluzione adatta a GPU diverse. Un altro è fare operazioni di post-processing sulla grafica integrata, ma ciò richiede di passare per il bus PCIe due volte.

Il terzo è svolgere carichi di computing asincrono come intelligenza artificiale, fisica, simulazione di particelle e ombre sulla GPU integrata. Intel ritiene che questo approccio sia il migliore perché il bus PCIe viene attraversato una sola volta: una GPU produce il contenuto e l'altra lo "consuma".

Lenovo ThinkPad X9-14 Aura Edition: leggero e sottile per i professionisti

Lenovo ThinkPad X9-14 Aura Edition: leggero e sottile per i professionisti REDMAGIC 10 Air: potenza da gaming in un corpo leggero e moderno. Recensione

REDMAGIC 10 Air: potenza da gaming in un corpo leggero e moderno. Recensione Insta360 X5: è sempre la regina delle action cam a 360 gradi. Recensione

Insta360 X5: è sempre la regina delle action cam a 360 gradi. Recensione Intel fa retromarcia: Intel Capital non diventerà indipendente

Intel fa retromarcia: Intel Capital non diventerà indipendente Phanteks Evolv X2: l'iconico case cambia e mette tutto in mostra

Phanteks Evolv X2: l'iconico case cambia e mette tutto in mostra Grizzly Lake: Intel porterà chip fino 32 core sulle automobili?

Grizzly Lake: Intel porterà chip fino 32 core sulle automobili? SK hynix continua a macinare numeri record grazie al boom dell'IA e NVIDIA

SK hynix continua a macinare numeri record grazie al boom dell'IA e NVIDIA Windows 11 24H2 fa emergere un bug vecchio di 20 anni in GTA: San Andreas. Sparisce l'idrovolante Skimmer

Windows 11 24H2 fa emergere un bug vecchio di 20 anni in GTA: San Andreas. Sparisce l'idrovolante Skimmer FBC: Firebreak, lo spin-off co-op di Control, uscirà a giugno

FBC: Firebreak, lo spin-off co-op di Control, uscirà a giugno Intel: il nuovo CEO annuncia azioni forti, ma per ora nessun licenziamento di massa

Intel: il nuovo CEO annuncia azioni forti, ma per ora nessun licenziamento di massa La missione Shenzhou-20 ha effettuato il docking con la stazione spaziale cinese Tiangong

La missione Shenzhou-20 ha effettuato il docking con la stazione spaziale cinese Tiangong Xbox Cloud Gaming arriva sulle TV LG: verifica se il tuo televisore è compatibile

Xbox Cloud Gaming arriva sulle TV LG: verifica se il tuo televisore è compatibile Stellantis: batterie allo stato solido in arrivo il prossimo anno, ricarica in 18 minuti

Stellantis: batterie allo stato solido in arrivo il prossimo anno, ricarica in 18 minuti Effetto dazi, Logitech alza i prezzi fino al 25% negli USA: non è la sola tra aumenti e fuga

Effetto dazi, Logitech alza i prezzi fino al 25% negli USA: non è la sola tra aumenti e fuga Fondazione Carisbo entra in BI-REX. Obiettivo: accelerare e incubare startup

Fondazione Carisbo entra in BI-REX. Obiettivo: accelerare e incubare startup Dal 20 giugno 2025 arriva l'eco-label UE su smartphone e tablet: cosa cambia per i consumatori e venditori

Dal 20 giugno 2025 arriva l'eco-label UE su smartphone e tablet: cosa cambia per i consumatori e venditori Ionity installerà le prime colonnine Megawatt dell'italiana Alpitronic

Ionity installerà le prime colonnine Megawatt dell'italiana Alpitronic

6 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoSarebbe anche bello iniziassero ad implementarlo nei giochi, uno potrebbe anche riciclare la vecchia GPU per compiti relativamente leggeri e guadagnare qualche fps gratis (escludendo il consumo elettrico)

Ovvero io che ad esempio ho un 8750h con 630 integrata più 1070 full, riversando fisica, ombre ed altro sulla 630 potrei magicamente trovarmi i frame di un laptop che oggi monta 1080. Mica male

se il tutto fosse di facile implementazione,trasparente e democratico,cioe' che attraverso un driver e' possibile usarlo subito e su tutti i giochi e hw esistenti,allora si che sarebbe fantastico

ma quando stiamo a livelli di esempi di laboratorio,bisogno di supporto da parte delle swhouse,driver dai produttori hw,api di basso livello,ti rendi conto che ognuna pensa al suo torna conto

nelle migliori delle ipotesi potrebbe esserci qualche gioco "finanziato" ad operare in simbiosi,ma giusto cosi' per marketing,per farti credere che la cosa e' promettente e venderti il suo hw

ma nessuno ha interesse a collaborare gratis o peggio con i suoi concorrenti

alla fine converra' sempre una gpu migliore a qualche € in piu'

in questo caso molto meglio una 570,che spesso si trova gia' allo stesso prezzo della 560,e funziona meglio subito su tutti giochi,non devi attendere supporto di chicchessia solo su "qualche"

Ste fesserie che valgono solo su carta vennero promosse e proclamate più volte da AMD quando tentava di pubblicizzare la meglio che poteva le APU basate su Phenom e Bulldozer.

AMD

AMD lo fece veramente con le sue APU (Llano e successivi). Purtroppo nella maggior parte dei giochi il Crossfire tra integrata e dedicata andava peggio che usando solo la dedicata.Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".