Jetson AGX Orin, il nuovo cervello di NVIDIA per i robot è fino a 6 volte più potente

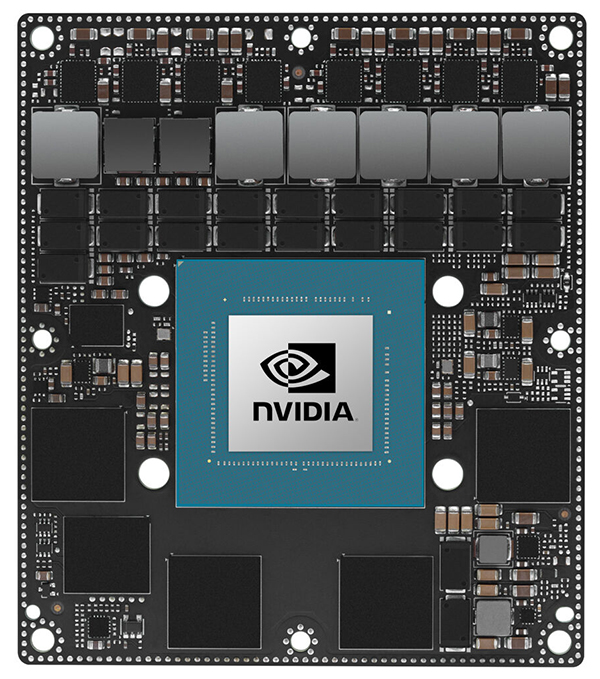

NVIDIA ha annunciato Jetson AGX Orin, una board di sviluppo per diversi settori embedded, tra cui la robotica e l'ambito sanitario, che grazie a 12 core Arm e una GPU Ampere offre fino a 6 volte più potenza di calcolo rispetto alla precedente Jetson AGX Xavier.

di Manolo De Agostini pubblicata il 10 Novembre 2021, alle 09:41 nel canale SistemiAmpereNVIDIAJetson

NVIDIA ha annunciato Jetson AGX Orin, una nuova board (o come lo definisce l'azienda "supercomputer IA") dedicata al mondo della robotica, delle auto autonome, dei dispositivi medici e "altre forme di computing embedded" che si preannuncia fino sei volte più potente rispetto all'attuale Jetson AGX Xavier.

Il SoC Orin di NVIDIA (17 mld di transistor) è dotato di 12 core Arm Cortex-A78AE "Hercules" con clock fino a 2 GHz, 32 GB di memoria LPDDR5 collegata tramite un bus a 256 bit (bandwidth di 204 GB/s) e una GPU Ampere con 2048 CUDA core che opera a 1 GHz. Il SoC contiene anche due Deep Learning Accelerators (DLA), un acceleratore per la computer vision e si appoggia a 64GB di storage eMMC 5.1.

"In settori come la robotica, l'assistenza sanitaria, la vendita al dettaglio, i trasporti e altri comparti essenziali la domanda di potenza di calcolo continua a crescere", ha affermato Deepu Talla, vicepresidente e direttore generale per l'embedded e l'edge computing di NVIDIA. "Jetson AGX Orin risponde a questa esigenza, consentendo agli 850.000 sviluppatori Jetson e alle oltre 6.000 aziende che costruiscono prodotti commerciali basati su di esso di creare soluzioni autonome e applicazioni di intelligenza artificiale che una volta sembravano impossibili".

Secondo NVIDIA, Jetson AGX Orin ha un TDP impostabile tra 15 e 50 Watt, ed è in grado di raggiungere (al massimo TDP) 200 TOPS con calcoli INT8 legati al machine learning. Il modulo (100 x 87 mm come la board precedente, con cui è "pin compatibile") e il kit per sviluppatori saranno disponibili dal Q1 2022 - gli interessati possono riceve una notifica registrandosi presso questa pagina.

Lenovo ThinkPad X9-14 Aura Edition: leggero e sottile per i professionisti

Lenovo ThinkPad X9-14 Aura Edition: leggero e sottile per i professionisti REDMAGIC 10 Air: potenza da gaming in un corpo leggero e moderno. Recensione

REDMAGIC 10 Air: potenza da gaming in un corpo leggero e moderno. Recensione Insta360 X5: è sempre la regina delle action cam a 360 gradi. Recensione

Insta360 X5: è sempre la regina delle action cam a 360 gradi. Recensione Intel fa retromarcia: Intel Capital non diventerà indipendente

Intel fa retromarcia: Intel Capital non diventerà indipendente Phanteks Evolv X2: l'iconico case cambia e mette tutto in mostra

Phanteks Evolv X2: l'iconico case cambia e mette tutto in mostra Grizzly Lake: Intel porterà chip fino 32 core sulle automobili?

Grizzly Lake: Intel porterà chip fino 32 core sulle automobili? SK hynix continua a macinare numeri record grazie al boom dell'IA e NVIDIA

SK hynix continua a macinare numeri record grazie al boom dell'IA e NVIDIA Windows 11 24H2 fa emergere un bug vecchio di 20 anni in GTA: San Andreas. Sparisce l'idrovolante Skimmer

Windows 11 24H2 fa emergere un bug vecchio di 20 anni in GTA: San Andreas. Sparisce l'idrovolante Skimmer FBC: Firebreak, lo spin-off co-op di Control, uscirà a giugno

FBC: Firebreak, lo spin-off co-op di Control, uscirà a giugno Intel: il nuovo CEO annuncia azioni forti, ma per ora nessun licenziamento di massa

Intel: il nuovo CEO annuncia azioni forti, ma per ora nessun licenziamento di massa La missione Shenzhou-20 ha effettuato il docking con la stazione spaziale cinese Tiangong

La missione Shenzhou-20 ha effettuato il docking con la stazione spaziale cinese Tiangong Xbox Cloud Gaming arriva sulle TV LG: verifica se il tuo televisore è compatibile

Xbox Cloud Gaming arriva sulle TV LG: verifica se il tuo televisore è compatibile Stellantis: batterie allo stato solido in arrivo il prossimo anno, ricarica in 18 minuti

Stellantis: batterie allo stato solido in arrivo il prossimo anno, ricarica in 18 minuti Effetto dazi, Logitech alza i prezzi fino al 25% negli USA: non è la sola tra aumenti e fuga

Effetto dazi, Logitech alza i prezzi fino al 25% negli USA: non è la sola tra aumenti e fuga Fondazione Carisbo entra in BI-REX. Obiettivo: accelerare e incubare startup

Fondazione Carisbo entra in BI-REX. Obiettivo: accelerare e incubare startup Dal 20 giugno 2025 arriva l'eco-label UE su smartphone e tablet: cosa cambia per i consumatori e venditori

Dal 20 giugno 2025 arriva l'eco-label UE su smartphone e tablet: cosa cambia per i consumatori e venditori Ionity installerà le prime colonnine Megawatt dell'italiana Alpitronic

Ionity installerà le prime colonnine Megawatt dell'italiana Alpitronic

9 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoMa non vedo più da tempo core ARM basati su Project Denver: ormai nVidia utilizza le classiche IP ARM.

Si vede che ha abbandonato il suo core ARM.

/OT

Si vede che ha abbandonato il suo core ARM.

/OT

Ho lavorato con i proci famiglia Carmel con GPU Volta. Delle bestie di processori per l'epoca ma NVIDIA ha fatto di tutto per complicare il più possibile la vita degli sviluppatori: già solo arrivare a caricare il kernel era un delirio fra partizioni protette e contro partizioni (non ti dico cos'è calcolare un hash ad un livello così basso), ma poi ad esempio anche la gestione del boot del core R5 safety che in teoria si fa in 30 righe era resa molto difficile dalle scelte di NVIDIA (se fatta fuori dall'ambiente ubuntu consigliato).

Praticamente uscire dalla pessima distro ubuntu che davano a disposizione era davvero dura, se poi come nel mio caso dovevi scrivere il bootloader toccava fare un giro a Lourdes. Mancavano tante cose fra cui il supporto a KVM o Xen, le patch RT che dovetti portare con una versione custom del kernel e tante altre cose che resero poco popolari quelle soluzioni.

Credo che sia anche per questo che sono tornati verso architetture più standard, eccetto ovviamente la parte video. Certo è che è stato un lavoraccio ma anche un piacere scrivere per quelle CPU, in 35W erano dei piccoli mostri per l'epoca.

Praticamente uscire dalla pessima distro ubuntu che davano a disposizione era davvero dura, se poi come nel mio caso dovevi scrivere il bootloader toccava fare un giro a Lourdes. Mancavano tante cose fra cui il supporto a KVM o Xen, le patch RT che dovetti portare con una versione custom del kernel e tante altre cose che resero poco popolari quelle soluzioni.

I consumi non erano superiori rispetto ai core ARM dell'epoca con prestazioni simili? Visto che non era un'architettura ARM, ma doveva ricorrere a un traduttore in parte hardware, e ha parecchia memoria come cache per i blocchi di codice tradotti, penso che avrebbe dovuto consumare di più rispetto a una soluzione nativa.

Loro davano per scontato che i dev avrebbero usato la versione di Ubuntu preparata da Nvidia e magari cambiato il kernel. Non li ha sfiorati l'idea che qualcuno volesse far girare applicazioni barebone o che per varie ragioni qualcuno potesse avere bisogno di scrivere il bootloader.

In ogni caso anche la stabilità degli strumenti software al 2020 non era delle migliori, ricordo il programma per fare il flash dell'OS falliva non deterministicamente (cioè a parità di condizioni ogni tanto non ci riusciva) e personalmente non sono mai riuscito a farlo funzionare via ethernet, ma solo via usb.

Nota che in altre piattaforme della famiglia Jetson non era così, ad esempio le Jetson piccole (Nano e Tx2) erano molto più stabili. Credo che il problema sia stato nella grandissima complessità di gestione introdotta con la famiglia di proci "grandi" e la volontà di inserire feature forse (azzardo) troppo complesse rispetto allo standard dei sistemi embedded per automotive e all'esperienza di NVIDIA stessa nel settore.

Aveva una GPU che le altre soluzioni si sognavano, giustificavano i consumi così.

EDIT Alla fine per me è stata un'esperienza positiva, sono entrato in contatto con diversi maintainer del kernel linux ed ho visto un mondo che non conoscevo, però ecco... non abbiamo ricomprato un'altra soluzione di Nvidia per sistemi "embedded".

Grazie per le spiegazioni. Quindi, come pensavo, il valore aggiunto non era la CPU, ma la GPU.

confermo

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".