|

|

|

Quote:

La 3070ti da 16gb quando la 3080 ne ha 10 esiste solo nella fantasia dell'utenza, e anche dovesse arrivare, si sa che prima o poi cio' che oggi è all'ultimo grido domani è obsoleto, sticazzi non ce li metti? :O Quando tu compri, qualunque cosa sia, è "oggi" non domani. Anche la mia macchina quando l'ho presa mi entusiasmava ma oggi la getterei in un fosso :asd: Allora non compriamo nulla, si passerà ai 5nm e ai chip "modulari" al prossimo giro, ste schede sono tutte merda fumante, no? :D Ma anche quelle è, TSMC avrà pronti i 3nm prima di fine 22 :asd: |

Quote:

|

Quote:

|

Quote:

Quote:

Quote:

Per il resto, compri una scheda adesso per giocare a control col riflessino di lei sui vetri oggi perché domani spenderai altri 1000 per giocare bene all'oggi (di domani)? fortuna che ci si lamenta sempre dei prezzi in salita |

Quote:

|

|

Quote:

|

|

Quote:

|

Quote:

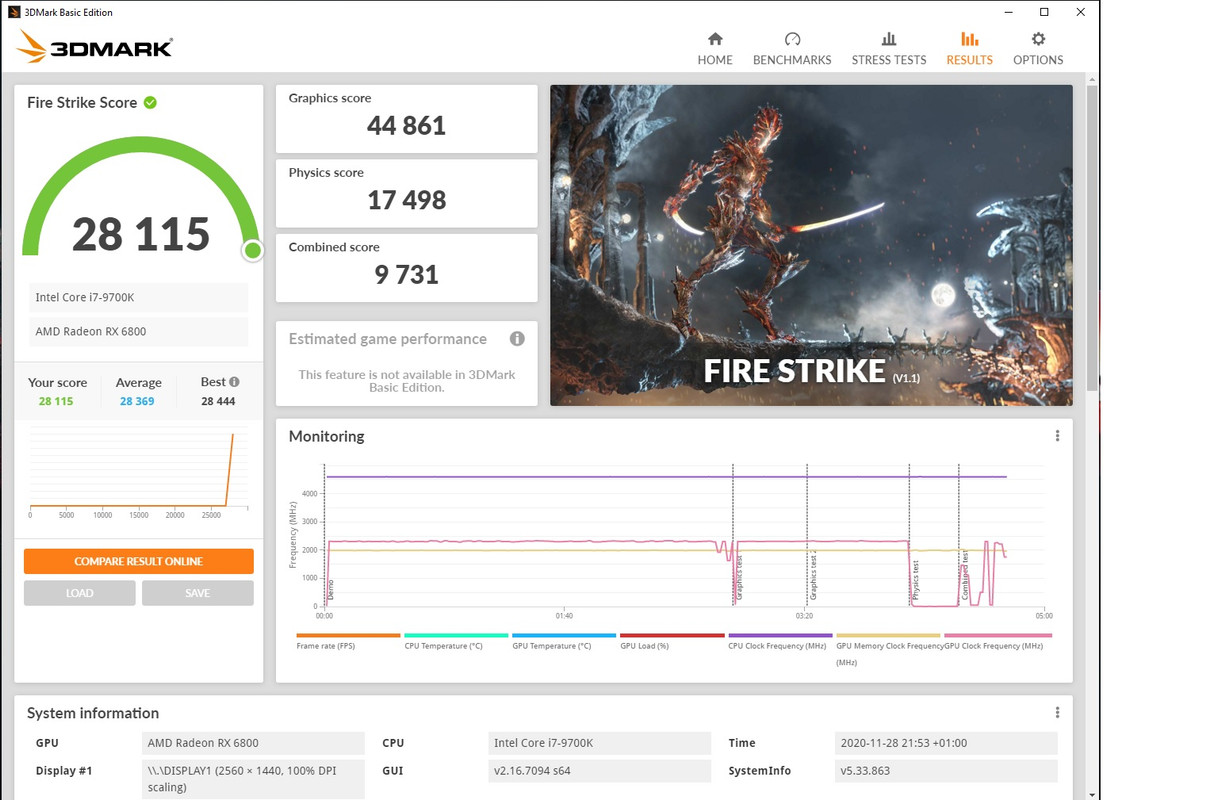

io ho sempre e solo lamentato gli 8 della 3070 :read:, e lo sa anche l'ultimo degli utenti del thread verde per quante volte credo di averlo ripetuto :asd:. Della 3080 ho sempre detto quello che ho detto sopra, che 10gb sono sufficienti perchè sono quello che avranno più o meno a disposizione le nuove console dei 16 a loro disposizione una volta sottratte le risorse per il SO e per il codice di gioco che comprende audio, ia, fisica ecc.. Certo ho anche detto che con 12 sarebbe stata meglio col bus full 384, ma non mi sono mica lamentato :asd: Ah e il 3dmark non è una "tech demo che azzoppa amd", sennò non postavi tutto "trionfante" i sintetici della stessa casa quando erano a favore della 6800 o no? cos'è, azzoppano amd o sono veritieri a convenienza tua a sconda del risultato? quello dedicato all'rtx, è fatto dalla medesima software house e non è sponsorizzato nvidia, anzi, nella stessa pagina di presentazione dello stesso hanno fatto un bocchino ad amd dicendo "l'egemonia di nividia in rtx è finita"...solo che poi il risultato prodotto da amd non ha supportato l'assist che le avevano fatto con un risultato sconcertante: va la metà. La roba nuova tarata su rdna 2 significa che girerà anche su AMD in versione "low setting", non che andrà meglio su PC. Vediamo come evolverà, di certo sarebbe positivo, ma per la miliardesima volta, OGGI, non è cosi. A ogni modo, spero che un giorno all'altro il tuo per nulla cringe e insensato attaccamento per un'azienda che non sa manco che esisti trovi una spiegazione sensata, no perchè tu parli, parli, parli per difenderli come fossero tuoi parenti e poi non gli compri manco na cpu da che han fatto il primo ryzen che tanto hai vantato e al massimo gli prendi i fermacarte come la 580 ogni papa morto...gli spezzeresti il cuore a lisona se solo sapesse :O |

Mi permetto di fare una considerazione dopo aver letto centinaia di post.

Premetto che anche io sono molto indeciso su quale sara' la prossima scheda (andro' a sostituire una evga 1080ti che rulla con 9900K@5000 all core su un Alienware AW3418DW 3440x1440@120mhz), e tuttora le idee sono confuse. Partiamo dal presupposto che se uscisse una 3080ti 20 GB a 900 euro si taglierebbe la testa al toro ......... :D :D Ragioniamo sulle due antagoniste 3080 vs 6800xt..... Oramai si e' eviscerato tutti i pro ed i contro di una e dell' altra. La realta e' che i prezzi sono stragonfiati se non addirittura irreali. Pero' nessuno ha fatto notare una cosa... vi e' sfuggito il periodo in cui siamo entrati? Lasciamo perdere sto cazzo di Covid che secondo me centra poco con l' hardware, siamo praticamente alle porte del Natale ... Ma lasciano perdere la scimmia che e' in noi cosa ci siamo sempre detti tra smaliziati consumer.... che questo e' il peggior periodo per comprare hardware.... ce lo siamo dimenticati tutti? Da Novembre a tutto Gennaio il periodo peggiore, poi dopo si comincia pian piano a rientrare nella normalita' e poi fine primavera e' il periodo migliore, intendo sotto profilo del mercato prezzi disponibilita'. Quindi perche' tanto meravigliarci della situazione attuale, studiata ben bene dai vari marketing aziendali per mettercela in quel :ciapet: Ora e' chiaro che la 3080 tuf a 739 come i preordini a settembre permettevano (preordini sian ben chiaro) o 6800xt a 685 come alcuni fortunati sono riusciti ad avere sono prezzi accettabili e che la scelta ricade secondo me sulla prima delle due che uno riesce ad avere. La differenza di prezzo ci sta, da una parte RT dall altra piu ram. Ma tutti gli altri prezzi non sono nemmeno da considerare.. e non parliamo poi dei prezzi di AMD che hanno fatto uscire; ma seriamente pensate di comprare una scheda a quel prezzo? Big Navi e' sicuramente un ottimo progetto, un ottimo prodotto (se riesco la prendero' pure io) ma deve costare comunque dai 50~100 in meno della 3080 altrimenti siamo fuori Questo per dirvi ed anche per AUTOCONVICERMI :sofico: aspettiamo aspettiamo e compriamo la prima che viene disponibile al prezzo giusto. E che la scimmia sia sempre con NOI !!!!! Fabrizio |

Quote:

Poi logico, se riesci a prendere una 6800xt all'msrp e per le 3080 vogliono 800€ e forse ti arriva fra un mese o due, lì si possono fare altre valutazioni... Resta il fatto che amd finalmente ha tirato fuori una roba paragonabile nella fascia enthusiast, non succedeva da tipo 10 anni, io mi accontenterei di quello, considerando il salto generazionale han fatto un miracolo |

Quote:

Sono post su post che lo dico e mi avete ignorato in modo spregevole :D :D :D |

Quote:

|

Quote:

|

Quote:

|

Quote:

Che 10GB siano sufficienti l'avevo scritto. Certo se spendi certe cifre avere un serbatoio future proof schifo non fa. Sui consumi parliamo di 60-70Watt quando ti va bene.. non sono pochi, e in OC con 3080 arriveresti a 400W.. Quindi altro piccolo potenziale vantaggio in performance che comunque va considerato anche se poi a te non interessa. RT di oggi vale come il 2 di picche. Per te è indispensabile ma per altri attualmente è una mezza crepa. Sono 70 usd sul prezzo. La 3080 reference a 699 dove sarebbe?? Non esiste, e chi la comprerebbe? Hanno tutte per forza dei dissipatori custom generosi. E la reference di AMD ha un dissipatore di qualità non un blower, puoi considerarla alla pari della "FE". Per me è giusto paragonare 649 a 719 e visto che costano molto, un 10% di sconto schifo non fa. Sicuramente ci sono molte altre differenze sia a favore e contro di entambe da valutare. La mia risposta non voleva essere una polemica verde rossa ; rispetto la tua preferenza e quella di alessandro ma è l'affermare: "lo dicono i numeri, non i secondo me" ad essere "intelletualmente disonesto" ed "oppugnabile". Secondo me la 6800xt è preferibile, sono libero di avere i miei motivi. Tu sei libero di pensare che "secondo te" io sia uno stolto; non mi offendo. |

Quote:

Sottolineo poi il "AL MOMENTO" del mio precedente commento, è possibile che con il tempo la 6800xt si riveli più prestante causa driver/più ram, ma attualmente sta sotto la 3080. Poi ripeto, li ritengo due prodotti assolutamente comparabili, son nella stessa fascia, non è che una sia merda l'altra sia cioccolata. E riallacciandomi ad un paio di commenti visti in qualche pagina fa, si dice sempre peste e corna del software amd, ma nvidia quando si decide di passare al nuovo millennio? Ho provato una 2060 per un po', l'interfaccia geforce sembra targata 1998, ma come mai sta cosa? |

Quote:

L'interfaccia AMD è fantastica, mi mancherà:) |

| Tutti gli orari sono GMT +1. Ora sono le: 20:35. |

|

Powered by vBulletin® Version 3.6.4

Copyright ©2000 - 2024, Jelsoft Enterprises Ltd.

Hardware Upgrade S.r.l.