|

Quote:

|

Sono riuscito ad ordinare una rx 6800 dal sito amd. Ho pagato con paypal senza registrarmi al sito.

Mi è arrivata solo le email di paypal che confermava il pagamento, ma nessuna email di conferma da AMD. :confused: Cosa devo fare? i soldi sono stati scalati |

Per mia esperienza ti dico che sei riuscito a prenderla, a me la mail amd è arrivata ore ed ore dopo

|

Quote:

a te dopo quanto è arrivata? |

Quote:

|

Quote:

|

Quote:

|

Quote:

danzare nudo per strada urlando come un insensato. Se ti ferma la polizia, dille cosa sei riuscito ad acquistare e dove, ti lasceranno andare. |

Quote:

|

Quote:

Sul sito di Amd non si crea un account. Se i soldi ti sono stati scalati allora è fatta! All'email da te indicata ti arriverà la nota di Amd con il riepilogo dell'ordine ed il link dove poter visionarne lo stato di avanzamento. ;) |

Quote:

|

Quote:

|

Mi stavo domandando:

Essendo open, il supersampling di amd funzionerà pure su Nvidia? Inviato dal mio Pixel 2 XL utilizzando Tapatalk |

Quote:

https://www.dsogaming.com/news/amd-c...tform-feature/ |

Quote:

|

voglio una cavolo di schedaaaaaaaaaaaaaaaaaaa:muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro: :muro:

|

che vuol dire?

Non hai l'autorizzazione per accedere a "http://www.amd.com/en/graphics/amd-radeon-rx-6000-series" su questo server.

Riferimento # 18.a8346868.1606763534.5bc4727d:D :D :mad: :mad: :mad: |

Quote:

|

Quote:

|

Ma qualcuno è riuscito a comprare una xt oggi? Io vedo se riesco a prendere la 6900xt l'8 dicembre ma temo sarà impossibile

|

Quote:

:P Scherzi a parte, attendo con impazienza Martedì 8 con molta impazienza (e con altrettanto scalpitare attendo anche il 5950X questa settimana *_*), quindi ti capisco e buona fortuna. :) |

Quote:

poi de gustibus, c'è ancora chi gioca con l'amiga e gode come un riccio ugualmente :D |

la xt costerà 1014 euro da noi

|

Quote:

l'amiga è inarrivabile anche con 10000 fps rtx on :O |

Quote:

|

Ma poi si è capito se i problemi di riflessioni evidenziati da alcune recensioni di watch dogs Legion è un problema driver o meno ? :read:

|

salve ragazzi

rientro oggi dopo anni a far parte delle rosse e devo dire hanno margini-prestazioni assurde chiedo a voi se durante il game eccessiva una temperatura max di 72 dopo ore di bf 5 neanche mi ero accorto dalla foga averle lasciate in auto o minimo al 25% se le alzo non va sopra i 50 gpu@4700mhz quasi piu della cpu :eek:  |

aggiornato i driver e ho superato i 17000 al timespy con scheda video stock, ma la frequenza non ha superato i 2200mhz in boost. a voi stock fino a quanto boosta?

dovrei provarla su un pc "normale" per capire se il problema è il mini itx (le temperature sono buone però). |

|

Quote:

|

Quote:

|

si ragazzi limite 1v@2700mhz

0.950 crasha ram stock ....perchè....con slider@2150mhz va ma lampeggia lo schermo... voi a temp come state ? |

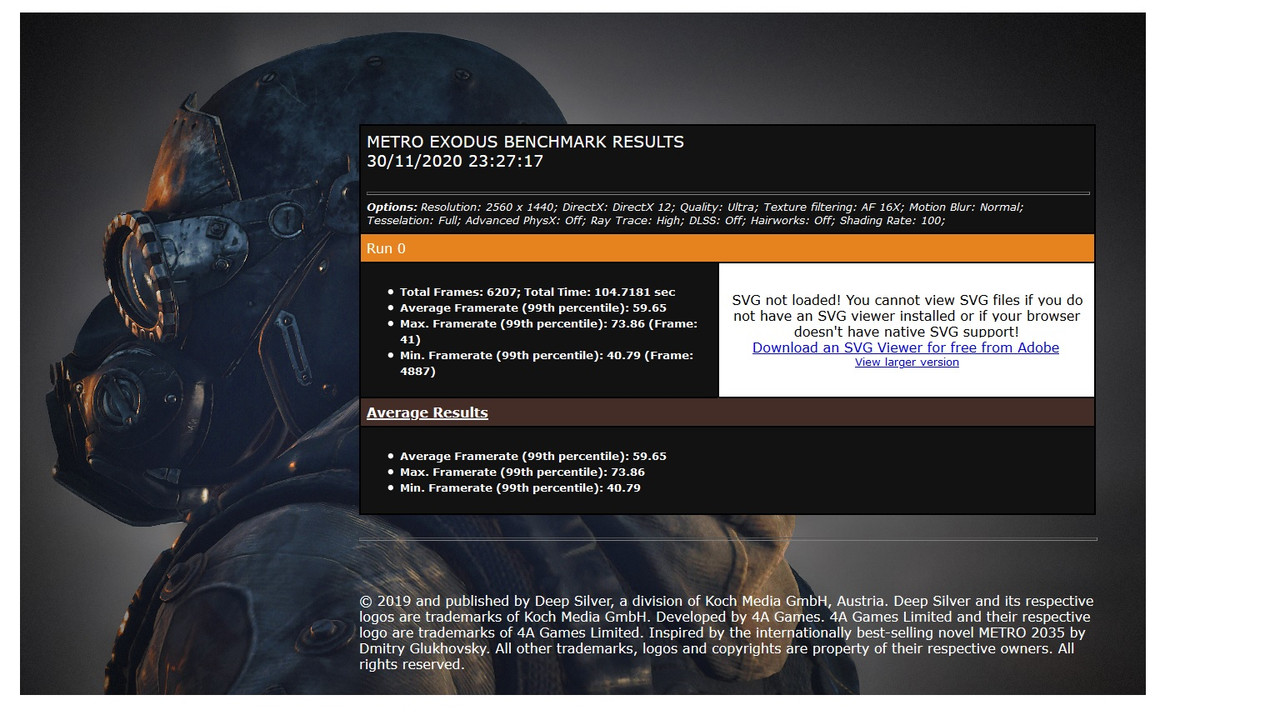

Ma questo benchmark è compatibile con le RX 6800?

https://www.surgicalscalpels.com/rtbenchmark.html Se volete testare il raytracing è bello pesante. |

Boh a me ancora nessuna email di conferma da AMD:rolleyes:

|

Quote:

|

Quote:

|

link diretto allo shop amd per la 6800?

|

Quote:

|

Quote:

|

| Tutti gli orari sono GMT +1. Ora sono le: 07:27. |

Powered by vBulletin® Version 3.6.4

Copyright ©2000 - 2024, Jelsoft Enterprises Ltd.

Hardware Upgrade S.r.l.