|

PhysX su G84 (8600GTS), da prendere con cautela, anche perchè non so il tedesco e non ci ho capito una bega di quello che c'è scritto la. :stordita: :asd:

|

Quote:

EDIT: ecco infatti avevo ragione "NVIDIA publishes the following diagram with relative performance results of the most popular physics algorithms in PhysX." Dai magari questa sera sistemo bene la prima pagina. :) |

Quote:

|

Quote:

|

Diciamo l’unica cosa che frena per comprare una vga ATI è il discorso ''fisica nei game''

Sicuramente Nvidia non ha comprato Ageia per fare numeri in 3Dmark Vantage, x ciò prevedo una quantità notevole di giochi con supporto physx. Ora vorrei capire se sarà un standard e sarà compatibile con le vga ATI o rimane esclusiva Nvidia?! Qst cosa secondo me è molto piu importante di dx10.1.. |

Quote:

Un pò come è successo fin'ora in tutti i giochi che utilizzano Physx :fagiano: |

Quote:

|

http://www.hwupgrade.it/news/skvideo...uda_25845.html

Ragione o meno, su una cosa siamo certi, Intel sta rosicando. :asd: |

Quote:

1)Lo standard X86 esiste solo per le CPU (anzi solo per una parte di CPU) e non può essere adattato al GPGPU senza stravolgerlo. Larrabbee sarà pure X86 compatibile ma dubito che un compilatore per questa architettura avrà molto in comune con uno per Pentium 2)Cuda è una tecnologia proprietaria che si basa su uno standard che più standard non si può: il linguaggio C. Il problema dell'architettura sarà tale per chi, come Nvidia, dovrà scrivere dei compilatori o dei tool di sviluppo che traducono le istruzioni C del programma nel linguaggio macchina della GPU. Per un programmatore che scrive programmi GPGPU in C cosa può interessare se poi l'hw che eseguirà quel codice non è X86 compatibile? Il C è uno standard nato su server Unix che funzionano da millenni informatici prima che Intel creasse l'X86. 3)Il GPGPU è una nuova forma di programmazione che sfrutterà un hw molto diverso dalle cpu esattamente come la nascente programmazione 3D in DirectX o OpenGL quindici anni fa. Allora per far nascere la miliardiaria industria dei vg su pc bastò creare uno standard. Non ebbe nessuna importanza il fatto che questo standard non avesse niente in comune con le CPU e l'X86. La stessa cosa vale oggi. Si può creare uno standard anche senza l'X86, forse alla Intel sopravvalutano un pò troppo le loro tecnologie. |

Quote:

Quote:

|

ciao ragazzi, mi iscrivo perchè interessato.

ho installato i drivers 177.35 scaricati da qui: http://www.nvidia.com/object/cuda_get.html validi per tutte le serie 8 e superiori (da quanto c'è scritto) senza bisogno di modificare gli inf. |

un programmatore di guru 3D ha rilasciato un tool...

per attivare disattivare il physics da qui il nome nv physics tweaker.. link -> http://downloads.guru3d.com/NV-PhysX...load-1984.html |

Quote:

Vogliamo bench da voi che potete. :O |

Una notizia che non riguarda physx , ma dx10.1 e gddr5 per le prossime vga nvidia.

Interessante.. http://www.tgdaily.com/content/view/38247/135/ |

Quote:

Quindi avremo un GT300 molto interessante, per la top azzardo un 384bit, 1536Mb di VRAM GDDR5. Ho aggiunto il link all'utility in prima pagina, notte gente. :) |

Quote:

;) |

Ho un dubbio..io sapevo che ageia vendeva delle schede da affiancare alla vga, alle quali era dato il compito di fare i calcoli per la fisica, nei pochi giochi supportati.

Ora che physx è nelle nvidia, la fisica dovrebbe essere più curata. Ora mi chiedo: i calcoli che prima facevano le schede esterne, ora, li fa la vga? credo proprio di si da quanto leggo. ma se la vga deve fare i suoi calcoli + la fisica, non si avrà un'abbassamento di frames medi?? |

Quote:

il compito della fisica non lo sente neanche. La cpu invece lo sente un po' quello della fisica, quindi mai scaricare alla cpu, soprattutto per i cpu limited. se hai una VGA che ne risente allora è troppo vecchia, è da buttare. |

Quote:

co sti ultimi driver poi il calo è un po' difficile visto che con gli 177.41 hanno ingranato ancora di più le prestazioni. a favore di chi è cpu limited, per i giochi supportati ovvio, |

Quote:

Le GPU non sono più potenti delle CPU, lo sono solo in alcuni ambiti, ossia il calcolo in virgola mobile e il calcolo parallelo. Quote:

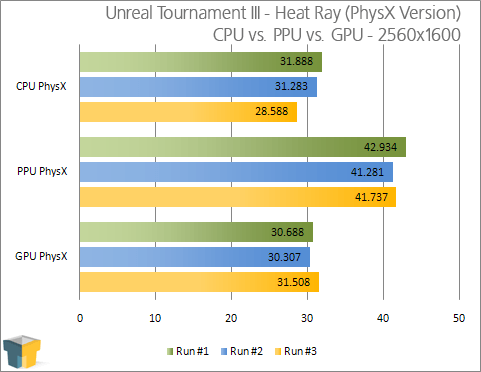

La risoluzione è di 2560x1600, situazione assolutamente non-CPU limited (tranne magari con i 3-Way SLi di GTX 200). Inoltre: Unreal Tournament III is one of the few games out there that has the ability to utilize all four cores in your Quad-Core, and I have in the past seen it hit 100% on multiple cores during specific tests. What we should take from this is that even though the physics can be off-loaded to the GPU, the CPU still plays an important role. Possiamo vedere come il framerate sia sostanzialmente uguale sia con CPU che GPU PhysX, questo mostra che la CPU lavora sempre al suo massimo, infatti nel caso del GPU PhysX, il framerate è comunque inferiore anche se la CPU è sgravata, per via della mancanza di potenza da parte della GPU. Possiamo inoltre notare come nel caso del PPU PhysX i frame siano superiori, visto che sia CPU che GPU possono dare il loro massimo. |

Quote:

|

Iscritto ;)

Ho scaricato i driva 177.41 e poi messo i PhysX...spero di aver fatto bene anche perche il vantage è passato da 8600 a 8600 non credo che siano risultati in linea! |

no infatti.

|

a sembra che con i driver PhysX mi sia salita la temperatura della gpu (77° in full su GRID , 75° su Mass Effect ) mentre prima il picco massimo era stato su Crysis ( 72° )

|

Quote:

però dovete elencare i programmi che servono , perchè non sono un fanatico di benc. |

scusate l'avrete ripetuto 1000 volte .... ma potete ripeterlo e aiutarmi ... devo installare su windows vista 64 i driver della scheda video .. vorrei installare questi con la nuova opzione i 177.41 ???:rolleyes: .... per adesso ho i 175.19 ??? c'è con questi driver si perde o si migliore come fluidità ??? e per farli funzionare sulla mia 8800 gts 512mb , come in prima pagina ..... attraverso una modifica del file .inf dei driver ..... :confused: ????

grazie mille |

Quote:

Quote:

Se la notizia fosse vera, però, le DX10.1 sarebbero qualcosa in più del mero marketing, evidentemente. ;) |

CPU vs GPU

GPU: tante unità aritmetiche semplici, bandwidth esagerato CPU: branch prediction, superscalare, unità aritmetica complessa, ottima gestione della cache. Round 1: GPU Test:"Cambia la luminosità di una immagine da 10 Mps" "Fatto!" CPU: Test:"Cambia la luminosità di una immagine da 10 Mps" "Cambio al pixel 1 Cambio al pixel 2 Cambio al pixel 3 .... Cambio al pixel 1.032.312 ... uff uff ... Cambio al pixel ...." etc Nonostante i clock molto più alti della CPU, la GPU può processare tutto in parallelo. Round 2: GPU: Test:"Se a è diverso da b, vai a c altrimenti prosegui" "Emm.. scusa dov'è esattamente che devo andare?" "A c, se a è diverso da b" "Sicuro, si?" "Si, altrimenti prosegui" "Altrimenti che?... dai non farla difficile!" ... ... "Senti, se ti ricambiassi la luminosità all'immagine di prima?" CPU: Test:"Se a..." "Fatto!" "Ehi!, ma devo ancora finire la domanda!" "Potenza del branch prediction, cocco!" Sulle "decisioni" la GPU entra in crisi e possono rallentare completamente le sue operazioni. Le CPU sono anni che vengono ottimizzate per far quello. Verdetto: calcoli e algoritmi complessi su un "ristretto" insieme di dati->CPU calcoli e algoritmi "semplici" su un grande insieme di dati->GPU. Nota di colore: Processore ARM Test:"Se a..." "Vado a c." "Ehi!, ma devo ancora finire la domanda!" "Zi, ma il compilatore mi ha fatto la soffiata di andare a c" :D |

Non ho capito bene una cosa riguardo il branch prediction, sulle CPU è molto evoluto, ma sulle GPU? Cosa comporterebbe importare un branch prediction da CPU su una GPU?

Sono domande ignoranti, visto che il mio livello tecnico si ferma molto prima. :stordita: |

Quote:

Tanto è vero che normalmente nella memoria video della scheda video vengono contenuti i dati da processare, mentre nei registri contenuti nei vari gruppi di alu ci sono le varie costanti, o pochi byte di dati che vengono passati spessissimo alle funzioni contenute nei vari threads.. Almeno questo è quello che mi sembra di aver capito leggicchiando la documentazione di cuda, magari qualcuno che ha effettivamente programmato con cuda potrà dare conferma o meno.. |

Quote:

Ma senza andar troppo nei dettagli, suppongo però che il fatto che un "core" CPU sia 100 volte più grande di un "core" GPU conti qualcosa. ;) Inoltre la maggior parte dello spazio del core CPU (mi sembra 70-80% o giù di li) è occupato da logica decisionale, predittiva, di controllo, e sopratutto dalla memoria cache. Mentre quando si parla di "core" GPU in effetti si parla di unità aritmetiche dure e pure. |

I PhysX Driver 8.06.12 vanno sia su OS 32 che 64 bit?

|

Quote:

|

Quote:

|

Quote:

perdonatemi ma i driver 177.41 che ho scaricato in italiano sul sito dellla nvidia sono per la serie 9 e GT200 .... come faccio a farli funzionare anche co la mia 8800 gts ??? grazie mille |

Quote:

|

1 Allegato(i)

Quote:

te lo metto in allegato qui.. ciao |

defragg perchè non agg. il 1° post con i 177.41 e metti pure l'inf allegato... per questi drivers?

|

Quote:

|

1 Allegato(i)

Quote:

no no.. quelli sono per xp32bit.. non mi avevi accennato all'so per il 64bit sempre in allegato ciao |

| Tutti gli orari sono GMT +1. Ora sono le: 17:38. |

Powered by vBulletin® Version 3.6.4

Copyright ©2000 - 2024, Jelsoft Enterprises Ltd.

Hardware Upgrade S.r.l.